产品优势

大模型一体机开箱即用,全面适配国产算力

DeepSeek大模型一体机,助力金融、政府及企业客户实现智能化升级。

DeepSeek大模型一体机提供从底层算力到模型服务、推理能力及应用开发的完整解决方案,全面适配国产算力,兼具高性能与高性价比。

• 支持多种大模型参数规格,满足不同客户的需求,为客户提供灵活的配置选项。

• 结合RAG检索增强能力,平台能够对全网内容进行深度分析,生成精准的结构化答案,满足企业知识库与行业数据的高效检索需求。

• 实现“数据不出域、性能更高效”,确保数据安全的同时,提升服务效率,真正为企业提供智能化服务。

托管大模型极速部署,一键启动

网宿算力云平台,助力开发者与企业高效部署大模型语言应用

在初始部署大模型时,开发者与企业常被环境配置繁琐、耗时久及部署失败率高所困扰。网宿算力云平台为解决这些难题,提供了最佳方案。

• 支持 DeepSeek-R1 大模型语言应用直接部署,依托超大规模 GPU 算力资源和预训练镜像与完整依赖环境,一键即可拉取并启动服务。

• 分钟级开启托管大模型服务,相比传统数天的部署时长,网宿平台大幅缩短部署时间,还能规避环境冲突,降低失败风险。

• 助力开发者与企业快速上手,大幅提升开发效率,让企业能够更专注于业务创新与价值创造。

灵活API接入与联网增强搜索,赋能业务创新

网宿DeepSeek API,助力企业低成本、高效、快速接入人工智能时代

在人工智能时代,企业急需低成本、高效、快速地接入 DeepSeek。网宿DeepSeek API 提供简单易用的接口,满足企业多样化需求。

• 通过简单易用的API接口,用户可直接调用DeepSeek R1/V3满血版功能,快速集成模型能力,助力企业加速智能化转型。

• 结合网宿互联网检索增强技术,深度分析全网内容,生成精准答案,提升企业搜索效率与决策能力。

• 提供精准、易用、高效的服务,同时依托网宿的技术实力和数据处理能力,保障业务稳定运行。

模型微调与推理优化,降本增效

网宿模型微调与推理优化服务,助力企业模型使用降本增效

模型推理服务通过硬件、软件、模型及数据处理的多重优化,显著提升推理速度与执行效率,降低推理成本,助力企业实现高效AI应用落地。

• 硬件优化:采用高性能计算硬件,加速模型推理过程,提升整体运行效率。

• 软件优化:优化推理框架与算法,减少计算资源消耗,提高推理速度。

• 数据处理优化:高效处理输入数据,减少数据传输与处理时间,进一步提升推理效率。

• 成本优化:通过资源合理分配与调度,降低推理成本,为企业节省开支。

GPU算力云部署

基于GPU算力云部署:

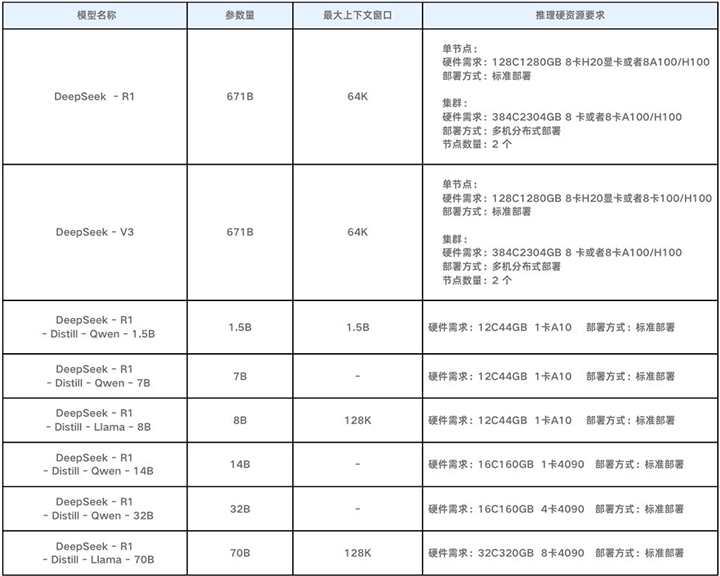

- 网宿算力云平台已支持DeepSeek-R1为基础的大模型语言应用的直接部署,结合大规模GPU算力资源快速部署环境,帮助开发者和企业用户简化部署流程,降低智算资源门槛,有效提升开发效率,从而带来更加高效便捷的AI开发和应用体验。

- 网宿算力云平台已上架最新版DeepSeek-R1 671B 推理模型,可支持 DeepSeek-V3和DeepSeek-R1-Distill的1.5B到70B蒸馏小参数模型预训练镜像,包含完整的依赖环境(CUDA驱动、框架库、加速引擎等),支持一键拉取并启动模型服务。传统模型部署需数天配置环境,使用网宿的镜像方式可压缩至分钟级,同时通过预测试的镜像规避环境冲突问题,降低因依赖版本差异导致的部署失败风险。

DeepSeek一体机部署

API调用+模型托管

API调用及模型托管

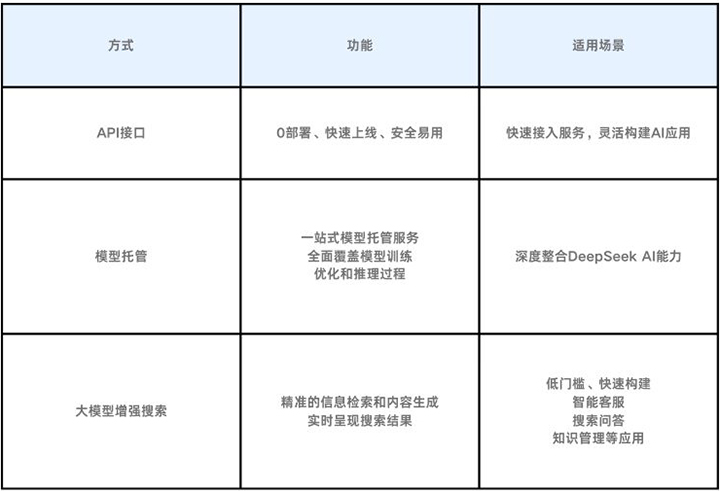

- API接入服务:通过灵活、易用的API,直接调用DeepSeek R1/V3满血版接口。

- 联网增强搜索:结合RAG检索增强能力,实现全网内容的深度分析与精准结构化答案生成。

- 模型微调服务:深入理解业务痛点和需求,利用先进的优化算法和计算资源,完成模型结构调整与参数优化,满足模型微调到推理。

- 模型推理服务:借助于硬件优化/软件优化/模型优化及数据处理优化的技术手段,提升推理速度和执行效率同时降低推理成本。

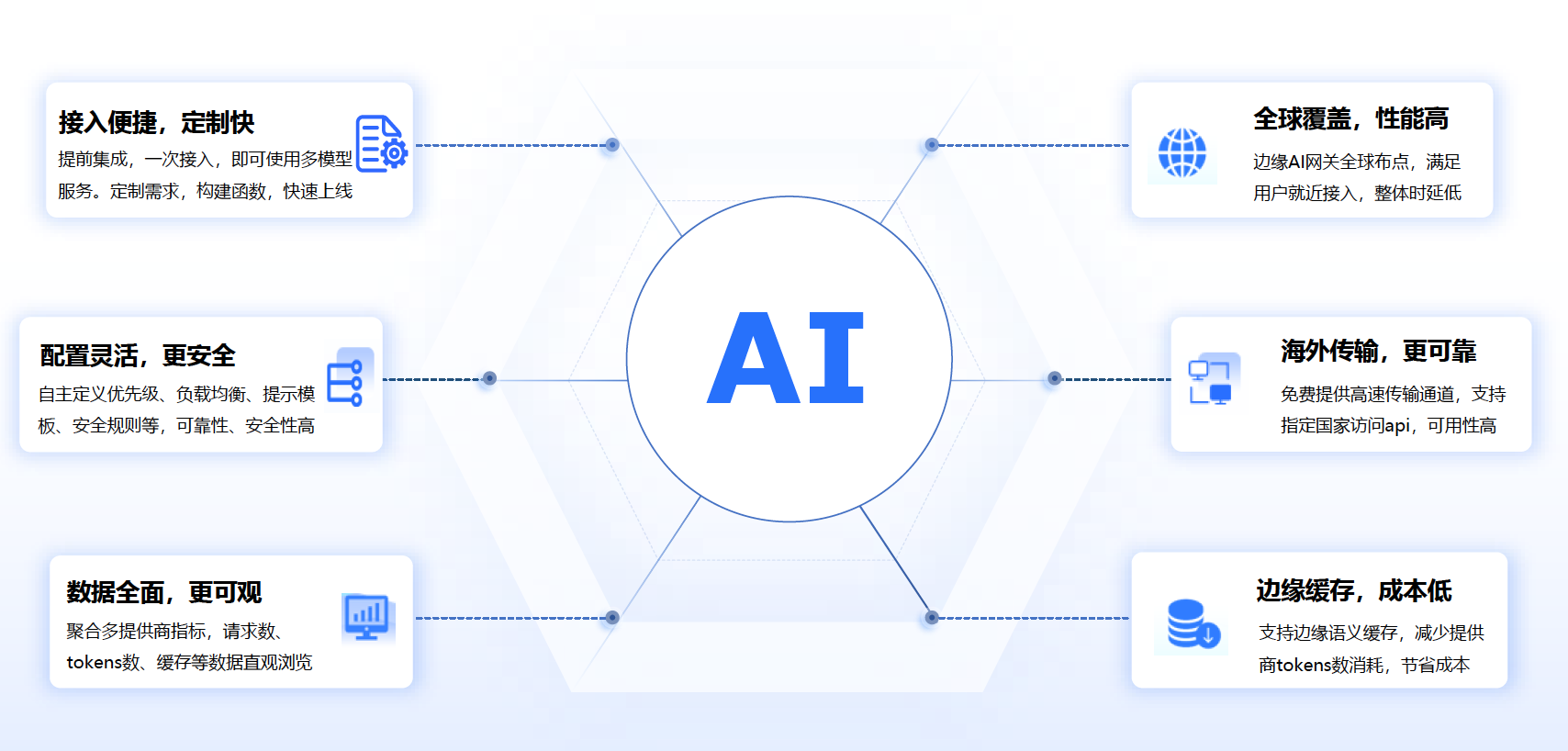

方案优势

-

联网搜索,提供百毫秒级的低延时搜索服务

-

全面提升内容精准度,允许用户直接查看网页全文,持全网信息搜索、归纳和分析

-

多模态搜索支持,支持HTML、Markdown、图片和视频等多种格式的内容搜索

详情咨询 (https://online.wangsu.com/product/ail)